Primeras predicciones de ciberseguridad e IA: una alianza (y amenaza) en evolución para 2026

En un escenario digital que evoluciona a velocidad luz, el vínculo establecido entre la ciberseguridad y la inteligencia artificial empieza a vislumbrar nuevos escenarios y amenazas para 2026. En este artículo repasaremos algunas tendencias de amenazas para el año entrante, y algunas lecciones que nos dejan hechos recientes.

Los agentes de IA como vector definitivo de ataque

Un reciente análisis de BeyondTrust, publicado por TheHackerNews revela cómo algunos de los vectores de ataque tradicionales están siendo reemplazados por otros donde la inteligencia artificial juega un papel decisivo. Este cambio de paradigma advierte que la adopción acelerada de IA sin una base de seguridad sólida puede dejar a las organizaciones vulnerables frente a riesgos emergentes.

La integración de agentes de IA, es decir, herramientas autónomas que deciden y actúan dentro de los sistemas, se convierte para 2026 en un reto central de seguridad. Según BeyondTrust, este tipo de IA estará conectada prácticamente con “toda tecnología que operamos”, actuando como un nuevo middleware en las organizaciones. El problema principal radica en la velocidad de adopción: muchas implementaciones están empujadas por el mercado, mientras que la seguridad queda rezagada.

Una de las amenazas asociadas a este impulso es el llamado “confused deputy”. Este surge cuando un agente de IA, que dispone de privilegios legítimos para cumplir tareas específicas (por ejemplo, acceder a correos o a bases de datos), es engañado por un actor malicioso. El agente, operando dentro de sus permisos, acaba realizando acciones que benefician al atacante, como exfiltrar datos, desplegar código malicioso u obtener privilegios superiores. Ante esto, se recomienda tratar a los agentes de IA como identidades privilegiadas: aplicar políticas de “mínimo privilegio”, controles de acceso basados en contexto, filtrado de comandos y auditoría en tiempo real.

Contenido falso, engaño a chatbots y desinformación a la orden del día

En el horizonte de 2026, uno de los retos más complejos para todos será la proliferación de contenido falso y manipulado mediante IA.

Estudios recientes difundidos por DarkReading revelan que los motores de búsqueda basados en IA, así como los sistemas de recomendación, pueden ser engañados con relativa facilidad mediante lo que se denomina AI cloaking o “encubrimiento” de contenido, diseñada específicamente para agentes de IA y no para usuarios humanos. Por ejemplo, una investigación de SPLX documenta como páginas web ofrecen contenido legítimo a usuarios humanos, pero cuando identifican que quien consulta es un bot de IA, sirven una versión fabricada con información falsa que luego es reproducida por el sistema de IA como “verdad”. El peligro reside en que los sistemas de IA no verifican la veracidad del contenido que consumen, y pueden replicar de forma confiada narrativas engañosas, sesgadas o directamente inventadas.

Dicho riesgo se extiende también al ámbito político y social: según el criptógrafo y experto en seguridad Bruce Schneier, la IA ya ha comenzado a intervenir en procesos democráticos y en la construcción de opinión pública. Schneier explica que la inteligencia artificial tiene el potencial de convertirse en un actor principal del mundo político: los modelos de IA podrían llegar a funcionar como agentes políticos que conocen nuestras preferencias, deliberan por sí mismos y nos ayudan a encontrar puntos en común en discusiones. Al mismo tiempo que el incremento del uso analítico, creativo y generativo para las campañas, ya es moneda corriente.

La importancia de desconfiar

En el contexto laboral, la confianza en las herramientas de IA también está bajo sospecha: un reciente informe revela que documentos legales generados con ayuda de inteligencia artificial presentaron errores graves, como citas a casos inexistentes, lo que expone el riesgo de depender en exceso de IA sin supervisión humana. Abogados han encontrado más de 490 documentos legales que presentaban “alucinaciones” de IA, en los últimos seis meses, según un investigador francés. Este escenario plantea que, para 2026, las empresas no solo deben capacitar a sus empleados en el uso de IA, sino también reforzar los procesos de verificación para evitar que esta tecnología se convierta en un enemigo más que en un aliado.

Algo similar habíamos visto hace un tiempo, cuando publicamos un estudio realizado por Bellingcat sobre la geolocalización con IA: nunca hay que confiar ciegamente.

Una amplia gama de ataques

Más que una tendencia, ya es una realidad, pero probablemente se incremente en el año entrante. Los sistemas de IA ya no solo están expuestos a fallos de seguridad tradicionales: están siendo directamente atacados. Desde la manipulación de sus datos de entrenamiento hasta el engaño de interfaces que parecen inofensivas, los atacantes buscan que la IA se comporte de forma inesperada o sirva como vector de ataque.

Recientemente, se ha descubierto que con apenas 250 documentos contaminados se puede “envenenar” un modelo de LLM, logrando insertar un backdoor o puerta trasera que se activa con una frase desencadenante y hace que el modelo se comporte de forma maliciosa. Lo más importante es que esto se logró incluso en modelos muy grandes que se presuponía que eran más robustos. Esto abre un nuevo panorama: el flujo de datos utilizados por la IA se vuelve tan relevante para la ciberseguridad como el propio modelo.

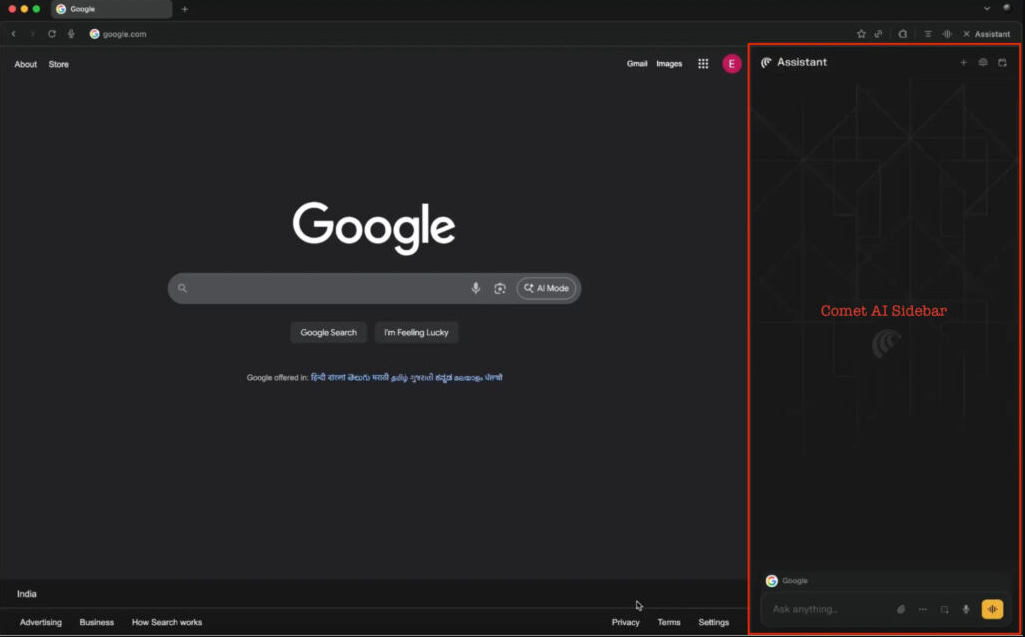

Por otro lado, aparecen cada vez más vectores “visibles”, por ejemplo, la suplantación de interfaces de IA en navegadores o ataque de spoofing de barras de navegación.

Un nuevo ataque aprovecha extensiones maliciosas para reemplazar la barra lateral del asistente de IA en navegadores como Comet o Atlas. Aparenta ser legítima y, sin que el usuario lo advierta, lo guía a actividades maliciosas como phishing, instalación de malware o autorización fraudulenta de cuentas. Este ataque no compromete el modelo de IA directamente, sino que explota la confianza del usuario en una herramienta tan rutinaria como el navegador.